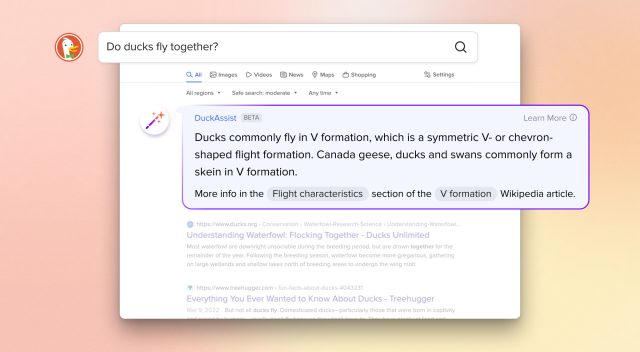

Pour ne pas être en reste de la précipitation à intégrer l’IA générative dans la recherche, DuckDuckGo a annoncé mercredi DuckAssist, un service de résumé factuel alimenté par l’IA et alimenté par la technologie d’Anthropic et d’OpenAI. Il est disponible gratuitement aujourd’hui en tant que test bêta étendu pour les utilisateurs des extensions de navigateur et des applications de navigation de DuckDuckGo. Étant alimenté par un modèle d’IA, la société admet que DuckAssist pourrait inventer des choses, mais espère que cela se produira rarement.

Voici comment cela fonctionne : si un utilisateur de DuckDuckGo recherche une question à laquelle Wikipédia peut répondre, DuckAssist peut apparaître et utiliser la technologie de langage naturel de l’IA pour générer un bref résumé de ce qu’il trouve dans Wikipédia, avec les liens sources répertoriés ci-dessous. Le résumé apparaît au-dessus des résultats de recherche réguliers de DuckDuckGo dans une boîte spéciale.

La société positionne DuckAssist comme une nouvelle forme de « réponse instantanée », une fonctionnalité qui évite aux utilisateurs d’avoir à fouiller dans les résultats de recherche Web pour trouver des informations rapides sur des sujets tels que les actualités, les cartes et la météo. Au lieu de cela, le moteur de recherche présente les résultats de la réponse instantanée au-dessus de la liste habituelle des sites Web.

DuckDuckGo ne dit pas quel grand modèle de langage (LLM) ou quels modèles il utilise pour générer DuckAssist, bien qu’une certaine forme d’API OpenAI semble probable. Crumpa a contacté les représentants de DuckDuckGo pour obtenir des éclaircissements. Mais le PDG de DuckDuckGo, Gabriel Weinberg, explique comment il utilise l’approvisionnement dans un article de blog d’entreprise :

DuckAssist répond aux questions en analysant un ensemble spécifique de sources – pour l’instant, il s’agit généralement de Wikipédia et parfois de sites connexes comme Britannica – à l’aide de l’indexation active de DuckDuckGo. Comme nous utilisons la technologie de langage naturel d’OpenAI et d’Anthropic pour résumer ce que nous trouvons sur Wikipédia, ces réponses devraient répondre plus directement à votre question réelle que les résultats de recherche traditionnels ou d’autres réponses instantanées.

Étant donné que le principal argument de vente de DuckDuckGo est la confidentialité, la société affirme que DuckAssist est « anonyme » et souligne qu’elle ne partage pas l’historique de recherche ou de navigation avec qui que ce soit. « Nous gardons également votre historique de recherche et de navigation anonyme pour nos partenaires de contenu de recherche », écrit Weinberg, « dans ce cas, OpenAI et Anthropic, utilisés pour résumer les phrases Wikipédia que nous identifions ».

Si DuckDuckGo utilise l’API GPT-3 ou ChatGPT d’OpenAI, on peut craindre que le site puisse potentiellement envoyer la requête de chaque utilisateur à OpenAI à chaque fois qu’il est invoqué. Mais en lisant entre les lignes, il semble que seul l’article de Wikipedia (ou un extrait de celui-ci) soit envoyé à OpenAI pour être résumé, pas la recherche de l’utilisateur elle-même. Nous avons également contacté DuckDuckGo pour obtenir des éclaircissements sur ce point.

DuckDuckGo appelle DuckAssist « le premier d’une série de fonctionnalités génératives assistées par l’IA que nous espérons déployer dans les mois à venir ». Si le lancement se passe bien et que personne ne le brise avec des invites contradictoires, DuckDuckGo prévoit de déployer la fonctionnalité à tous les utilisateurs de la recherche « dans les semaines à venir ».

DuckDuckGo : Risque d’hallucinations « fortement diminué »

Comme nous l’avons déjà expliqué sur Ars, les LLM ont tendance à produire des résultats erronés convaincants, que les chercheurs en IA appellent « hallucinations » en tant que terme technique dans le domaine de l’IA. Les hallucinations peuvent être difficiles à repérer à moins que vous ne connaissiez le matériel référencé, et elles surviennent en partie parce que les LLM de style GPT d’OpenAI ne font pas la distinction entre les faits et la fiction dans leurs ensembles de données. De plus, les modèles peuvent faire de fausses inférences basées sur des données qui sont par ailleurs exactes.

Sur ce point, DuckDuckGo espère éviter les hallucinations en s’appuyant fortement sur Wikipédia comme source : « en demandant à DuckAssist de ne résumer que les informations de Wikipédia et des sources connexes », écrit Weinberg, « la probabilité qu’il « hallucine » – c’est-à-dire juste inventer quelque chose – est grandement diminué.

Bien que s’appuyer sur une source d’informations de qualité puisse réduire les erreurs provenant de fausses informations dans l’ensemble de données de l’IA, cela peut ne pas réduire les fausses inférences. Et DuckDuckGo fait peser la charge de la vérification des faits sur l’utilisateur, en fournissant un lien source sous le résultat généré par l’IA qui peut être utilisé pour examiner son exactitude. Mais ce ne sera pas parfait, et le PDG Weinberg l’admet : « Néanmoins, DuckAssist ne générera pas de réponses précises tout le temps. Nous nous attendons à ce qu’il fasse des erreurs. »

Alors que de plus en plus d’entreprises déploient une technologie LLM qui peut facilement désinformer, cela peut prendre un certain temps et une utilisation généralisée avant que les entreprises et les clients décident quel niveau d’hallucination est tolérable dans un produit alimenté par l’IA conçu pour informer les gens de manière factuelle.